-

Llama 3.1 사용해 보기AI/Llama 2024. 9. 1. 11:55

Ollama & open-webui 한번에 설치

ollama 와 open-webui 를 따로 따로 띄웠더니, network 을 서로 못 찾는 듯 했다.

그래서 open-webui git repo 를 clone 받아 intellij 로 띄웠다

https://github.com/open-webui/open-webui

GitHub - open-webui/open-webui: User-friendly WebUI for LLMs (Formerly Ollama WebUI)

User-friendly WebUI for LLMs (Formerly Ollama WebUI) - open-webui/open-webui

github.com

intellij 의 docker 기능을 사용한다

그 전에 chrome browser 에서도 사용할 수 있도록

ollama 11434 port 도 등록해 준다

ports: - ${OLLAMA_WEBAPI_PORT-11434}:11434

intellij docker ui 사용하여 실행한다

참고 : intellij 의 docker settings

https://www.jetbrains.com/help/idea/docker.html

Docker | IntelliJ IDEA

www.jetbrains.com

https://www.jetbrains.com/help/idea/settings-docker.html

Docker connection settings | IntelliJ IDEA

www.jetbrains.com

ollama containers logs 확인 -> 정상

open-webui container logs -> 정상

chrome 에서도 ollama 확인

http://localhost:11434/

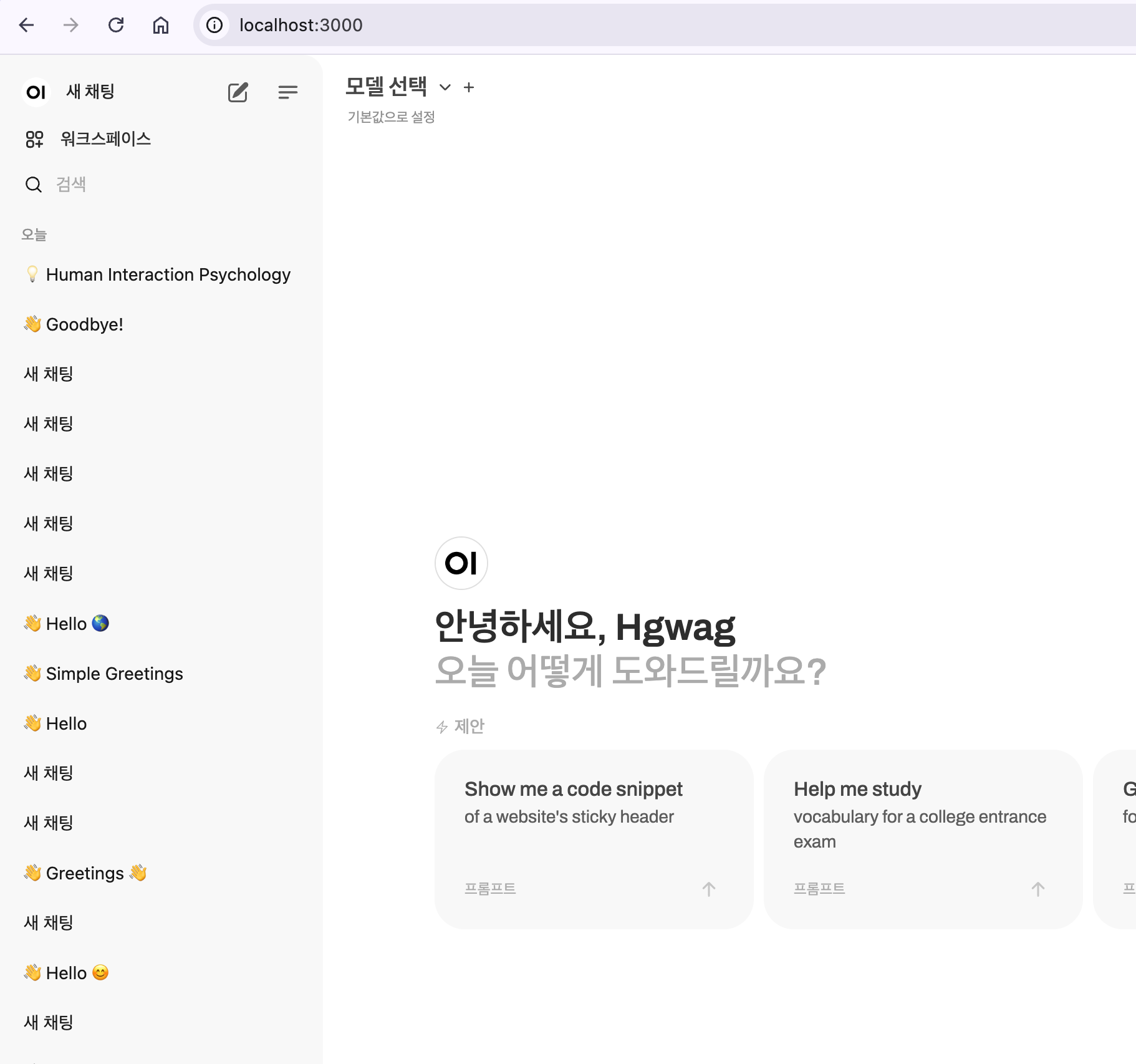

open-webui 도 잘 뜬다

http://localhost:3000/

첫 번째 회원가입 계정이 admin 이다

회원가입하고, admin 세팅 메뉴로 가서 model 을 등록한다

http://localhost:3000/admin/settings

이렇게 4개를 다운 받았다

llama3.1:8b

gemma2:2b

mistral-nemo:12b

qwen2:7bgemma2:2b 는 가벼워서 잘 돌아갔는데,

llama3.1:8b 는 500 error 가 발생한다

Ollama: 500, message='Internal Server Error', url='http://ollama:11434/api/chat'

ollama container logs 를 확인해보니, 메모리 부족이였다

level=WARN source=server.go:134 msg="model request too large for system" requested="5.9 GiB" available=3747893248 total="4.8 GiB" free="3.5 GiB" swap="0 B"

Rancher desktop 에 들어가서 memory 와 cpu 를 늘려주었다

memory 5G -> 8G

CPUs 2 -> 4

llama3.1:8b 도 작동한다...하지만 버벅댄다 ㅠㅠ

참고로

혹시 몰라 python 도 설치하였다

python 설치

https://techbukket.com/blog/python-start맥에서 파이썬 시작하기(아무것도 모르는 초보자용) | 테크버킷 블로그

이 글은 아무것도 모르는 상태로 파이썬(python)을 처음 시작하는 분들을 위한 초간단 가이드입니다. 파이썬을 실행하고 설치하는 방법을 설명하는 것이 어려운 이유는 파이썬을 설치하는 방법이

techbukket.com

intellij pycham 설치

https://www.jetbrains.com/ko-kr/pycharm/

PyCharm: 데이터 과학 및 웹 개발을 위한 Python IDE

www.jetbrains.com

Tips

bash 도 업데이트

/bin/bash --version # 4.x 최신 버전 업데이트 brew install bash sudo su echo "/opt/homebrew/bin/bash" >> /etc/shells chsh -s /opt/homebrew/bin/bashhttps://my-grope-log.tistory.com/37

'AI > Llama' 카테고리의 다른 글

ollama api 사용해 보기 (0) 2024.09.02